Sommet de Bergen: là où la bataille pour le réel devient réelle

L’industrie a enfin cessé de théoriser pour commencer à bâtir l’infrastructure destinée à préserver la vérité elle-même

Nous avons atteint le point d’inflexion. Pas celui que l’on analysera a posteriori, mais celui qui se déroule en ce moment même, lorsque le flot exponentiel de contenus générés par l’IA menace d’étouffer tout signal d’authenticité. Le Global Risks Report 2025 du Forum économique mondial ne mâche pas ses mots : la désinformation et la mésinformation se classent désormais parmi les dix principaux risques mondiaux pour la deuxième année consécutive, supplantant même le changement climatique et les conflits armés comme menaces existentielles immédiates.

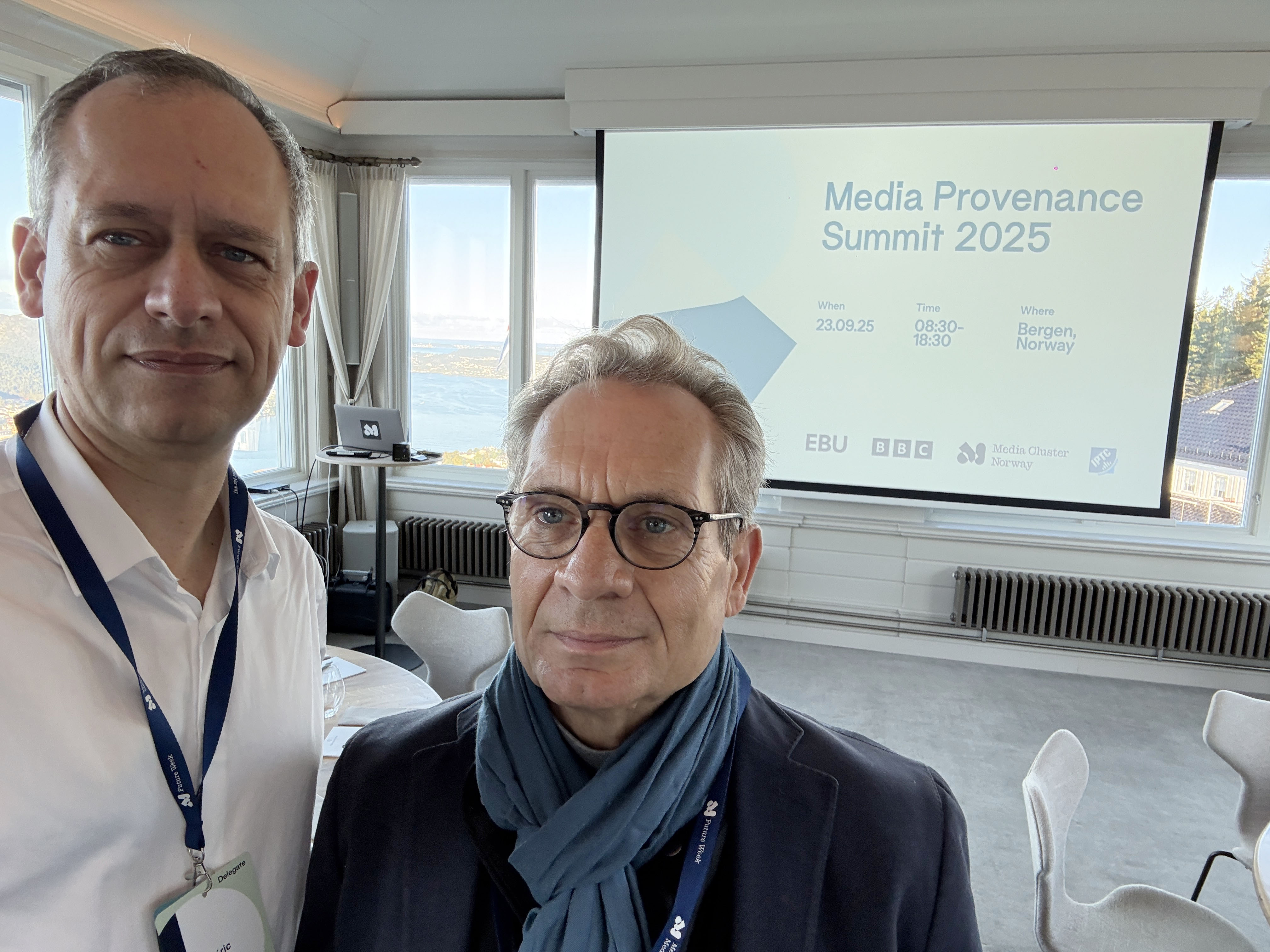

C’est dans ce contexte que, le 23 septembre 2025, un événement discret mais lourd de conséquences s’est tenu à Bergen, en Norvège. Alors que l’attention du monde se portait ailleurs, le Media Provenance Summit s’est réuni au Mont Fløyen, non pas pour une nouvelle séance de lamentations, mais pour entreprendre le travail plus ardu : trouver des solutions concrètes.

Pourquoi Bergen ? Pourquoi maintenant ?

L’hôte, Media Cluster Norway (anciennement Media City Bergen), s’est transformé d’une initiative régionale en catalyseur mondial de l’innovation technologique dans les médias. Ce qui avait commencé au début des années 1990, quand TV 2 obtint sa licence de diffusion, est devenu un écosystème de plus de 100 entreprises générant ensemble plus d’un milliard de dollars de revenus, incluant des acteurs de classe mondiale comme Vizrt, et soutenu par un solide réseau mêlant journalisme, technologie et recherche académique.

Mais l’implication de Media Cluster Norway va bien au-delà de la logistique. En 2023, l’organisation a rejoint Project Origin, le consortium mené par la BBC, le New York Times et Microsoft pour développer des solutions de provenance.

De là est né Project Reynir, une initiative ambitieuse visant à déployer le standard C2PA (Coalition for Content Provenance and Authenticity) à l’échelle de tout l’écosystème médiatique norvégien. Avec 10 millions de couronnes de financement d’Agenda Vestlandet et la participation de NRK, TV 2, Schibsted, NTB et Faktisk.no, Project Reynir vise 80 % d’adoption du C2PA dans les rédactions norvégiennes d’ici fin 2026, ce qui ferait de la Norvège le premier pays à adopter le standard à grande échelle.

Le sommet a été co-organisé par Media Cluster Norway, la BBC, l’Union européenne de radio-télévision (UER) et l’IPTC—une collaboration qui témoigne à la fois de l’urgence et de la coordination mondiale nécessaires pour relever ce défi d’infrastructure qui touche au cœur même de la démocratie.

Qui était présent

Ce n’était pas un salon de bavardages. Des participants venus du Japon, d’Australie, des États-Unis et du Canada ont rejoint leurs collègues européens à Bergen.

La liste ressemblait à un annuaire mondial de l’infrastructure médiatique : BBC, NHK, AFP, Getty Images, CBS, DPA, France Télévisions, CBC/Radio-Canada, ITN, PA Media, WDR, Sony, Adobe, ainsi que des fournisseurs technologiques tels qu’Imatag, Activo, Fotoware, Vizrt, Wolftech et Mimir. Leur présence rappelait aussi que les fabricants de matériel jouent un rôle décisif. Nikon, Sony et Google, par exemple, expérimentent déjà l’intégration des Content Credentials et du standard C2PA directement dans leurs appareils photo et smartphones. Car si l’authenticité ne débute pas au moment de la capture, aucune chaîne de confiance ne peut tenir.

Surtout, le sommet a rassemblé trois groupes rarement réunis dans la même salle : des médias aux prises avec les défis quotidiens de l’authenticité, des fournisseurs de technologies qui développent les outils, et des organismes de normalisation comme l’IPTC.

Cette convergence est cruciale car la mise en œuvre du C2PA n’est pas théorique—c’est un défi technique complexe qui exige coordination tout au long de la chaîne de production et de distribution des contenus.

Au-delà des keynotes : le vrai travail

La matinée a été consacrée aux présentations des pionniers. BBC, CBC/Radio-Canada, l’AFP et l’UER ont partagé leurs expériences d’intégration du C2PA dans des workflows existants. Pas de démos tape-à-l’œil, mais des récits francs sur les points de friction, les cas limites et la réalité chaotique du rétrofit d’une infrastructure de provenance dans des systèmes vieux de plusieurs décennies.

Mais ce sont les ateliers de l’après-midi qui ont montré où se situent les vrais enjeux. Parmi les défis débattus :

- Préserver les informations C2PA dans les workflows éditoriaux quand tous les outils ne sont pas encore compatibles. Chaque passage par une application non consciente du C2PA risque de briser la chaîne de provenance.

- À quel moment signer le contenu au fil du workflow : au niveau du dispositif, de l’organisation, ou des deux ? La réponse a des implications profondes sur la granularité de la vérification et les modèles de confiance.

- Confidentialité et vie privée, notamment la protection des sources. La transparence du C2PA peut se retourner contre les journalistes travaillant avec des témoins vulnérables ou dans des régimes autoritaires.

Ce ne sont pas des problèmes qu’on résout à coups de livres blancs élégants. Ils demandent une collaboration patiente et détaillée, quand des praticiens de différentes organisations comparent leurs notes et déboguent ensemble leurs implémentations.

Ce qui est vraiment en jeu

Ce qui échappe souvent dans ces sommets, c’est que le résultat n’est pas un communiqué ou une déclaration d’intention. C’est le savoir accumulé que les participants ramènent chez eux : des solutions spécifiques aux goulets d’étranglement, une compréhension partagée des points où les standards doivent être affinés, et des relations qui permettront de résoudre vite les problèmes futurs.

Comme l’a rapporté l’EBU, « Le sommet a insisté sur le passage de l’analyse des problèmes à l’exploration des solutions. Grâce à des sessions structurées, les participants ont défini les principaux blocages, esquissé des solutions pratiques et développé des plans d’action pour renforcer la confiance dans les médias numériques à l’échelle mondiale. »

Et c’est là tout l’enjeu : la provenance des contenus est un problème d’action collective. Si Getty Images adopte le C2PA mais que les médias ne le vérifient pas, le système échoue. Si les photographes capturent des métadonnées authentiques mais que les systèmes éditoriaux les effacent, le système échoue. Si la technologie fonctionne parfaitement mais que le public ne comprend pas les indicateurs, le système échoue.

L’effet domino au-delà des médias

Même si ce sont les médias qui ont convoqué ce sommet, les implications dépassent largement le journalisme. Tous les secteurs qui dépendent de la communication numérique font face à la même crise de crédibilité. Les procédures judiciaires exigent des preuves authentifiées.

Les marques d’e-commerce doivent se protéger des imitateurs générés par IA. Les systèmes d’information géographique ont besoin d’images satellites fiables. Les établissements d’enseignement doivent garantir la véracité de leurs sources.

L’infrastructure C2PA, aujourd’hui testée sous pression par les médias, deviendra la couche d’authentification de tout l’écosystème numérique. Quand Project Reynir atteindra son objectif de 80 % d’adoption en Norvège, les leçons tirées nourriront le déploiement dans la finance, la santé, la communication gouvernementale et l’entreprise à l’échelle mondiale.

Comme le dit Helge Svela, PDG de Media Cluster Norway : « La désinformation créée par l’intelligence artificielle n’est pas seulement un problème pour les médias – c’est un problème démocratique. Project Reynir est un coup d’accélérateur pour notre résilience numérique. »

Il ne s’agit pas seulement de lutter contre les deepfakes, il s’agit de poser une nouvelle couche fondamentale de confiance numérique.

Le travail continue

Une journée à Bergen ne résoudra pas la crise de l’authenticité. Mais elle représente quelque chose de plus précieux que des solutions : un processus. Le travail patient, peu glamour, de construction de consensus, de débogage des workflows et de création du savoir institutionnel nécessaire pour déployer une infrastructure d’authentification à grande échelle.

Les organisations présentes n’attendent pas des standards parfaits ou des technologies fluides. Elles mettent en œuvre dès maintenant, apprennent de leurs échecs, et partagent leurs découvertes avec leurs concurrents, conscientes que l’authenticité est un bien public urgent qui profite à tous ou à personne.

La prochaine fois que vous verrez un badge Content Credential sur une image de presse, rappelez-vous que derrière ce simple signe se cache un réseau mondial de journalistes, de techniciens et de normalisateurs qui se sont réunis dans des lieux comme Bergen pour que la chaîne de confiance tienne.

À l’ère du contenu synthétique infini, cette chaîne pourrait bien être la seule digue entre une démocratie éclairée et le chaos pur.

La question n’est pas de savoir si nous avons besoin de cette infrastructure. La question est de savoir si nous la construisons assez vite.